Bienvenido, me llamo Luis y hoy les traigo este nuevo artículo.

Índice

El Dr. Michio Kaku ha formulado una teoría de la conciencia muy interesante que se aplica a los sistemas de IA

Recientemente tuve un debate sobre IA fuerte versus débil con uno de mis nuevos pensadores favoritos en este mercado y me recordó algo que escribí hace más de un año.

Así que decidí desempolvarlo y reestructurar esos pensamientos en un nuevo artículo.

Desde un punto de vista tecnológico, suscribo la idea de que estamos a uno o dos avances de lograr alguna forma de IA fuerte o general. Sin embargo, desde un punto de vista filosófico, todavía existen varios desafíos que deben conciliarse.

Muchos de esos desafíos pueden explicarse por una teoría oscura impulsada por un matemático austrohúngaro en el siglo pasado y por una de las principales áreas de investigación en neurociencia.

En la teoría de la IA, la IA débil a menudo se asocia con la capacidad de los sistemas para parecer inteligentes, mientras que la IA fuerte está relacionada con la capacidad de pensar de las máquinas. Al pensar me refiero a pensar realmente y no solo a pensar de forma simulada. Este dilema a menudo se conoce como la «hipótesis de IA fuerte».

En un mundo que explora con asistentes digitales y algoritmos que superan a los campeones del mundo de GO y a los equipos de Dota2, la pregunta de si las máquinas pueden actuar de manera inteligente parece una tontería.

En entornos restringidos (por ejemplo, investigación médica, GO, viajes), hemos podido construir muchos sistemas de IA que pueden actuar como si fueran intelligen6.

Si bien la mayoría de los expertos están de acuerdo en que la IA débil es definitivamente posible, todavía existe un tremendo escepticismo cuando se trata de una IA fuerte.

¿Pueden pensar las máquinas?

Estas preguntas han perseguido a científicos informáticos y filósofos desde la publicación del famoso artículo de Alan Turing. «Maquinaria e inteligencia de cómputo» en 1950. La pregunta también parece un poco injusta cuando la mayoría de los científicos ni siquiera pueden ponerse de acuerdo sobre una definición formal del pensamiento.

Edsger Dijkstra quien en un artículo de 1984 comparó la cuestión de si las máquinas pueden pensar con preguntas como «¿Pueden nadar los submarinos?» o «¿pueden volar los aviones?».

Si bien esas preguntas parecen similares, la mayoría de los angloparlantes estarán de acuerdo en que los aviones pueden volar, pero los submarinos no pueden nadar.

¿Porqué es eso? Te dejo ese debate a ti y al diccionario; El meta-punto de esta comparación es que sin una definición universal del pensamiento parece irrelevante obsesionarse con si las máquinas pueden pensar.

Entre los principales argumentos en contra de una IA fuerte se afirma que, esencialmente, podría ser imposible determinar si la máquina realmente puede pensar. Este argumento tiene sus fundamentos en uno de los teoremas matemáticos más famosos de todos los tiempos.

Teorema de incompletitud de Gödel

Cuando hablamos de las más grandes teorías matemáticas de la historia que han tenido un gran impacto en nuestra forma de pensar, necesitamos reservar un lugar para Teorema de incompletitud de Gödel.

En 1931, matemático Kurt Gödel demostró que la deducción tiene sus límites al demostrar su famoso teorema de incompletitud. El teorema de Gödel establece que cualquier teoría formal lo suficientemente fuerte como para hacer aritmética (como la IA), existen enunciados verdaderos que no tienen prueba dentro de esa teoría.

El teorema de la incompletitud se ha utilizado durante mucho tiempo como una objeción a la IA fuerte. Los defensores de esta teoría argumentan que los agentes de IA fuertes no podrán pensar realmente porque están limitados por el teorema de la incompletitud, mientras que el pensamiento humano claramente no lo está.

Ese argumento ha provocado mucha controversia y ha sido rechazado por muchos practicantes de IA fuertes. El argumento más utilizado por la escuela de la IA fuerte es que es imposible determinar si el pensamiento humano está sujeto al teorema de Gödel porque cualquier prueba requerirá formalizar el conocimiento humano que sabemos que es imposible.

El argumento de la conciencia

Mi argumento favorito en el fuerte debate de la IA es sobre la conciencia. ¿Pueden las máquinas realmente pensar o simplemente simular el pensamiento? Si las máquinas son capaces de pensar en el futuro, eso significa que deberán ser conscientes (es decir, conscientes de su estado y acciones), ya que la conciencia es la piedra angular del pensamiento humano.

El escepticismo sobre la IA fuerte ha suscitado argumentos que van desde la teoría matemática clásica como Teorema de incompletitud de Gödel a las limitaciones técnicas puras de las plataformas de IA.

Sin embargo, el principal debate sigue siendo la intersección de la biología, la neurociencia y la filosofía y tiene que ver con la conciencia de los sistemas de IA.

¿Qué es la conciencia?

Hay muchas definiciones y debates sobre la conciencia. Ciertamente, lo suficiente como para disuadir a la mayoría de las personas cuerdas de seguir el argumento de su papel en los sistemas de inteligencia artificial.

La mayoría de las definiciones de conciencia involucran la autoconciencia o la capacidad de una entidad para ser consciente de sus estados mentales.

Sin embargo, cuando se trata de inteligencia artificial, autoconciencia y estados metálicos, tampoco están claramente definidos, por lo que podemos comenzar a bajar rápidamente por un agujero de conejo.

Para ser aplicable a la IA, una teoría de la conciencia debe ser más pragmática y técnica y menos, digamos, filosófica. Mi definición favorita de conciencia que sigue estos principios proviene del físico laureado Michio Kaku, profesor de física teórica en la Universidad de Nueva York y uno de los creadores de la teoría de cuerdas.

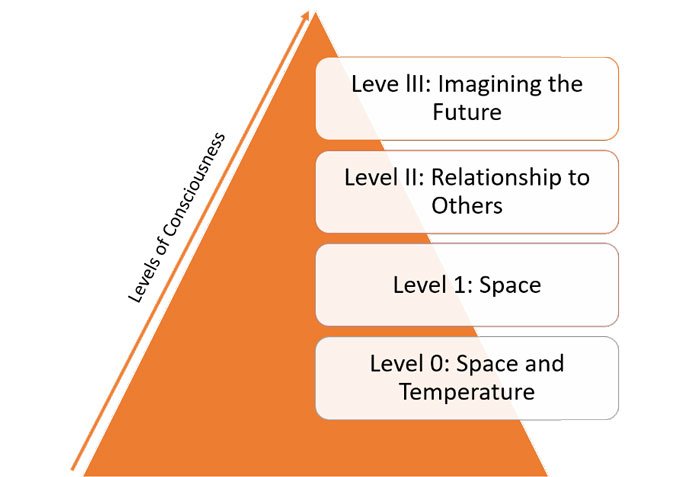

Hace unos años, el Dr. Kaku presentó lo que llamó la «teoría del espacio-tiempo de la conciencia» para reunir la definición de conciencia de campos como la biología y la neurociencia. En su teoría, el Dr. Kaku define la conciencia de la siguiente manera:

«La conciencia es el proceso de crear un modelo del mundo utilizando múltiples ciclos de retroalimentación en varios parámetros (por ejemplo, temperatura, espacio, tiempo y en relación con otros), con el fin de lograr una meta (por ejemplo, encontrar pareja, comida, refugio )»

La definición de conciencia del espacio-tiempo es directamente aplicable a la IA porque se basa en la capacidad del cerebro para crear modelos del mundo basados no solo en el espacio (como los animales) sino en relación con el tiempo (hacia atrás y hacia adelante).

Desde esa perspectiva, el Dr. Kaku define la conciencia humana como «una forma de conciencia que crea un modelo del mundo y luego lo simula en el tiempo, evaluando el pasado para simular el futuro». En otras palabras, la conciencia humana está directamente relacionada con nuestra capacidad de planificar el futuro.

Además de su definición central, la teoría del espacio-tiempo de la conciencia incluye varios tipos de conciencia:

- Nivel 0: Incluye organismos como plantas con movilidad limitada que crean un modelo de su espacio utilizando un puñado de parámetros como la temperatura.

- Nivel 1: Organismos como los reptiles que son móviles y tienen un sistema nervioso. Estos organismos utilizan muchos más parámetros adicionales para formar un modelo de su espacio.

- Nivel II: Organismos como los mamíferos que crean modelos del mundo no solo basados en el espacio sino en relación con otros.

- Nivel III: Seres humanos que comprenden la relación con el tiempo y tienen una capacidad única para imaginar el futuro.

¿Son conscientes los sistemas de IA?

La conciencia es uno de los temas de debate más apasionantes en la comunidad de IA. Por conciencia de IA, nos referimos a la capacidad de un agente de IA para ser consciente de su «estado mental».

La parte anterior de este ensayo presentó un marco iniciado por el conocido físico Dr. Michio Kaku para evaluar la conciencia en cuatro niveles diferentes.

Los reptiles y los insectos exhiben una conciencia de nivel 1 al crear modelos del mundo utilizando nuevos parámetros, incluido el espacio. La conciencia de nivel 2 implica la creación de modelos del mundo basados en las emociones y la relación con otras especies.

Los mamíferos son el grupo principal asociado con el nivel 2 de conciencia. Finalmente, tenemos humanos que pueden clasificarse en el nivel de conciencia 3 basados en modelos del mundo que involucran simulaciones del futuro.

Basándonos en el marco de conciencia del Dr. ‘Kaku, podemos evaluar el nivel de conciencia de la generación actual de tecnologías de IA. La mayoría de los expertos están de acuerdo en que los agentes de IA de hoy pueden clasificarse en el nivel 1 o en el nivel de conciencia muy temprano del nivel 2.

La clasificación de los agentes de IA en el Nivel 1 implica muchos factores, incluida la movilidad. Hoy en día, muchos agentes de IA han podido lograr movilidad y desarrollar modelos de su entorno basados en el espacio que los rodea.

Sin embargo, la mayoría de los agentes de IA tienen muchas dificultades para operar fuera de su entorno restringido.

La evaluación espacial no es el único factor que coloca a los agentes de IA en el nivel de conciencia I. La cantidad de ciclos de retroalimentación utilizados para crear modelos es otro factor muy importante a considerar.

Usemos el análisis de imágenes como ejemplo. Incluso los algoritmos de IA de visión más avanzados utilizan un número relativamente pequeño de ciclos de retroalimentación para reconocer objetos.

Si comparamos esos modelos con las capacidades cognitivas y los insectos y reptiles, parecen poco sofisticados. Entonces sí, la generación actual de tecnologías de IA tiene el nivel de conciencia de un insecto:

De manera constante, algunas tecnologías de IA han estado exhibiendo características de conciencia de nivel 2. Hay varios factores que contribuyen a esa evolución.

Las tecnologías de IA están obteniendo una comprensión más avanzada y simulando emociones, así como también percibiendo reacciones emocionales a su alrededor.

Además de la evolución de las técnicas de inteligencia artificial basadas en emociones, los agentes de inteligencia artificial se están volviendo más eficientes al operar en entornos grupales en los que necesitan colaborar o competir entre sí para sobrevivir.

En algunos casos, la colaboración grupal incluso ha resultado en la creación de nuevas habilidades cognitivas. Para ver algunos ejemplos recientes de agentes de IA que han exhibido conciencia de Nivel 2, podemos referirnos al trabajo de empresas como DeepMind y OpenAI.

Los agentes de IA mostraron comportamientos diferentes cuando los recursos eran abundantes que cuando eran escasos. El comportamiento cambió a medida que los agentes necesitaban interactuar entre sí.

Otro ejemplo interesante se puede encontrar en un experimento de simulación de OpenAI reciente en el que los agentes de IA pudieron crear su propio lenguaje utilizando una pequeña cantidad de símbolos para coexistir mejor en su entorno. Bastante bien, ¿eh?

Todavía hay días muy tempranos de soluciones de IA convencionales, pero mejorar el nivel de conciencia de los agentes de IA es uno de los objetivos más importantes de la generación actual de pilas de tecnología de IA. ¡La conciencia de nivel 2 es la próxima frontera!

Por el momento, la conciencia de nivel III en los sistemas de inteligencia artificial sigue siendo un tema de debate activo. Sin embargo, sistemas recientes como OpenAI Five o DeepMind Quake III han demostrado claramente la capacidad de los agentes de inteligencia artificial de planificación y colaboración a largo plazo, por lo que es posible que no estemos tan lejos.

La respuesta corta, y quizás sorprendente, es SÍ. Aplicando la teoría de la conciencia del espacio-tiempo del Dr. Kaku a los sistemas de IA, es obvio que los agentes de IA pueden exhibir algunas formas básicas de conciencia.

Teniendo en cuenta las capacidades de la generación actual de tecnologías de IA, colocaría la conciencia de los agentes de IA en el Nivel I (reptiles) o en el Nivel II básico.

Disfruta del artículo. Gracias por leer.

Añadir comentario